Am 7 Mai 2016 schaltete Joshua Brown den Autopilot seines Tesla Model S ein. Der Wagen fuhr mit voller Geschwindigkeit in einen LKW. Brown kam bei dem Zusammenstoss ums Leben (1). Während die Firma aussagt, dass sich Tesla statistisch gesehen gut hält – immerhin war es der erste Tod in 130 Millionen Meilen, was eine um einiges bessere Rate ist, als die in den U.S.A. übliche – wirft der Unfall Fragen über selbstfahrende Autos auf. Werden Fahrerinnen und Fahrer dem Autopiloten zu sehr vertrauen? Können die Autopiloten in Autos so intelligent werden, dass sich solche Unfälle in Zukunft vermeiden lassen? Können Menschen aufmerksam bleiben, wenn die Steuerung des Wagens vom Autopiloten übernommen wird? Ist ein durch den Autopiloten verursachten Tod schlimmer, d.h. schwieriger zu akzeptieren, als ein Tod der durch einen Fehler eines menschlichen Fahrers oder einer menschlichen Fahrerin verursacht wurde? Sind wir bereit, die Risiken zu akzeptieren, und falls nicht, wieso sind wir bereit diese Risiken im Falle von Flugzeugen zu akzeptieren? Sollen wir überhaupt selbstfahrende Autos besitzen?

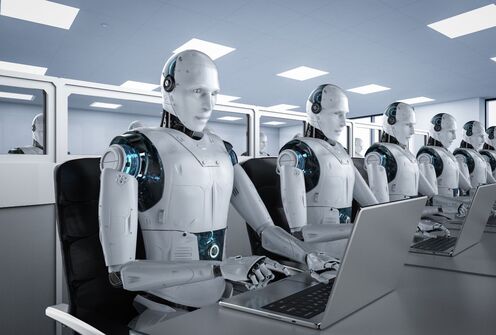

Diese Probleme betreffen nicht nur selbstfahrende Autos. Es gibt Pläne, allerlei Technologien in verschiedenen Lebensbereichen zu automatisieren. Fortschritte in den Bereichen Robotik und künstliche Intelligenz scheinen sich zu beschleunigen. Firmen wie Google stecken hohe Summen an Forschungsgeldern in diese Bereiche. Auch im Gebiet der Kriegsführung gibt es Automatisierungspläne (zum Beispiel Drohnen) und selbst im Gesundheitssystem – ein Bereich von dem traditionell angenommen wird, dass Menschen unersetzbar sind – werden sogenannte „Care Robots“ eingeführt. Die Automatisierung ist nicht mehr nur auf Fabriken beschränkt; die Roboter sind hier. Aber: was kann und soll überhaupt automatisiert werden? Sind wir bereit dieses Risiko zu tragen? Was sind die ethischen und rechtlichen Konsequenzen?

Obwohl immer intelligentere Maschinen entstehen, die Aufgaben übernehmen können von denen man glaubte, dass sie für Maschinen unmöglich seien – man denke an IBMs Watson (2) oder an Googles „DeepMind“ (3) – so kann doch nicht alles automatisiert werden. Dies liegt daran, dass Menschen eine andere Art von Intelligenz haben. Sie haben Körper und Emotionen; sie sind keine Maschinen. Sie sind biologische und kulturelle Geschöpfe. Sie können hochkreativ sein, und ihrer Welt Sinn geben. Sie empfinden – sie kümmern sich nicht umeinander um eine Aufgabe korrekt auszuführen, sondern können dies aus wahrhaft empfundener Zuneigung heraus tun. Sie können und sollen nicht auf Informationsverarbeitung reduziert werden. Sie sind keine Gegenstände; sie leben und empfinden. Menschen werden nie gänzlich von Maschinen ersetzt werden können.

Andererseits sind auch die Tage gezählt, in denen die Automatisierung auf simple Aufgaben beschränkt war. Immer komplexere Aufgaben können durch Algorithmen ausgeführt werden; oder so scheint es zumindest. Das Steuern von Autos ist eines von vielen Beispielen. Servicepersonal kann ersetzt werden. Man sagt auch, dass Journalistinnen und Journalisten, und sogar Ärztinnen und Ärzte in Zukunft ersetzbar sein werden. Forscher an der Universität Oxford sagen voraus, dass in den nächsten zwei Jahrzehnten 47% aller Arbeiten automatisiert werden können (4). Wenn dies Realität wird, müssen sich viele Menschen um ihre Arbeitsstelle sorgen. Dies geschah bereits im Zeitalter der Industrialisierung, und es könnte erneut geschehen, im von Erik Brynjolfsson und Andrew McAfee sogenannten „zweiten Zeitalter der Maschine“ (the second machine age) (5).

Doch selbst wenn weniger Arbeiten als vorhergesagt automatisiert werden und Menschen nebst den Robotern in vielen Arbeiten involviert bleiben, ist es wichtig, über die potentiellen psychologischen, ethischen und sozialen Konsequenzen der Automatisierung nachzudenken. Wie wird die Automatisierung unsere Erfahrungen von gewissen Handlungen wie etwa Schreiben und Kommunizieren umgestalten? Wie werden wir das Handeln an sich verstehen? Sollte die Automatisierung in einigen Bereichen, wie zum Beispiel dem Gesundheitssystem, eingeschränkt werden? Welche Arbeiten sollten wir an Roboter delegieren, und welche sollen wir Menschen selbst noch ausführen? Wie können Menschen und Maschinen in spezifischen Bereichen zusammenarbeiten? Auf welche Art von Gesellschaft bewegen wir uns zu, sollte der momentane Trend der Automatisierung fortdauern? Ist Automatisierung für alle gut? Wer werden die Gewinnerinnen und Gewinner sein, wer die Verliererinnen und Verlierer? Wie sollten wir politisch mit den Risiken und Herausforderungen der Automatisierung umgehen?

Selbst wenn es kein Roboter-Armageddon geben wird, selbst wenn Maschinen nicht alles gänzlich übernehmen werden, es ist wichtig diese ethischen und sozialen Fragen jetzt anzupacken, zu einer Zeit in der diese Technologien noch in der Entstehungs- und Testphase sind. Sonst bewegen wir uns blind und automatisch in eine Zukunft die niemand will.

References

- https://www.theguardian.com/technology/2016/jun/30/tesla-autopilot-death-self-driving-car-elon-musk

- https://en.wikipedia.org/wiki/Watson_(computer)

- https://en.wikipedia.org/wiki/Google_DeepMind

- oxfordmartin.ox.ac.uk/downloads/academic/The_Future_of_Employment.pdf

- http://secondmachineage.com/